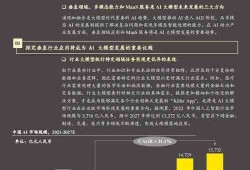

短视频算法推荐如何加剧信息茧房效应,机制与影响分析

- 毕业生论文

- 2025-04-04 03:12:55

- 9

短视频算法推荐通过用户画像与兴趣标签精准推送内容,虽提升用户粘性,却加剧了信息茧房效应,其机制表现为:1. **数据闭环**:算法基于历史行为(点赞、停留时长)持续强化同类内容推送,形成“越看越推”的循环;2. **窄化信息池**:优先分发高热度、强情绪化内容,挤压多元信息曝光机会;3. **即时反馈设计**:短视频的碎片化特性加速认知固化,用户被动陷入单一信息轨道。 ,影响层面:短期导致认知偏见加深,长期削弱社会共识基础,用户接触的信息高度同质化,难获跨圈层视角,加剧群体极化,平台为流量优化算法,进一步牺牲信息多样性,形成“算法-用户”双向强化的茧房结构,需通过透明算法、主动破圈推荐等方式平衡个性化与公共性。

随着短视频平台的普及,个性化推荐算法在提升用户体验的同时,也引发了信息茧房(Information Cocoons)现象的加剧,本文探讨了短视频平台算法推荐的工作原理,分析了其如何通过用户画像、协同过滤和强化学习等技术强化信息茧房效应,并讨论了该现象对个体认知、社会共识和公共舆论的潜在影响,本文提出了可能的优化策略,以期在个性化推荐与信息多样性之间寻求平衡。

:短视频平台、推荐算法、信息茧房、个性化推荐、信息多样性

信息茧房由哈佛大学教授凯斯·桑斯坦(Cass Sunstein)提出,指个体在信息获取过程中因偏好选择而局限于特定内容,导致认知窄化的现象,近年来,以抖音、快手、TikTok为代表的短视频平台通过强大的算法推荐机制,极大地提高了用户粘性,但也进一步强化了信息茧房效应,本文旨在探讨短视频推荐算法如何塑造用户的信息环境,并分析其对社会认知的潜在影响。

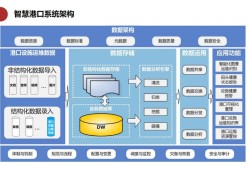

短视频推荐算法的工作原理

短视频平台的推荐系统主要依赖以下几种技术:

1 用户画像与协同过滤

平台通过收集用户的浏览记录、点赞、评论、停留时长等数据,建立精准的用户画像,协同过滤算法(Collaborative Filtering)则通过分析相似用户的行为,推荐可能感兴趣的内容,如果一个用户频繁观看健身视频,系统会持续推送相关主题,从而强化其兴趣偏好。

2 强化学习与反馈循环

推荐算法采用强化学习(Reinforcement Learning)不断优化推送策略,用户的每一次互动(如滑动、点赞、关注)都会作为反馈信号,使算法更精准地预测其偏好,这种机制导致用户逐渐陷入“越看越推,越推越看”的循环,进一步固化信息接收范围。

3 热度加权与长尾效应

平台通常会结合内容热度(如播放量、互动率)进行加权推荐,导致头部内容(如热门话题、网红视频)获得更多曝光,而小众或多元化内容被边缘化,加剧信息环境的同质化。

算法推荐如何强化信息茧房

1 内容同质化与认知窄化

由于算法倾向于推荐用户已表现出兴趣的内容,长期使用会导致信息环境高度同质化,政治立场偏激的用户可能只接收到符合其观点的信息,而忽略对立视角,加剧社会极化。

2 情感化内容优先

短视频平台更倾向于推荐情绪强烈(如愤怒、愉悦)的内容,因为这类视频更容易引发互动,长期接触极端化信息可能使用户的认知更加片面,削弱理性思考能力。

3 社交圈层固化

算法不仅影响内容推荐,还会影响社交关系,平台会优先推荐“兴趣相似”的用户,导致社交圈层逐渐封闭,进一步限制信息多样性。

信息茧房的社会影响

1 个体认知偏差

长期处于信息茧房中的用户可能形成“确认偏误”(Confirmation Bias),即只接受符合自身观点的信息,拒绝不同意见,导致认知僵化。

2 社会共识弱化

当不同群体接收的信息差异过大时,公共议题的讨论可能陷入对立,例如疫苗争议、政治立场分化等,加剧社会撕裂。

3 商业与政治操纵风险

信息茧房可能被商业或政治力量利用,通过精准推送影响用户决策,定向广告或虚假信息的传播可能因算法推荐而放大。

可能的优化策略

1 引入信息多样性机制

平台可调整算法,在推荐主流内容的同时,适当引入“反偏好”信息(如不同观点的新闻、小众兴趣内容),以打破信息茧房。

2 用户自主调节选项

提供“关闭个性化推荐”或“手动调整兴趣标签”的功能,让用户拥有更多信息选择权。

3 算法透明度与伦理监管

政府和行业组织应推动算法透明度,要求平台公开推荐逻辑,并设立伦理审查机制,防止算法滥用。

短视频平台的算法推荐在提升用户体验的同时,也加剧了信息茧房效应,影响个体认知和社会共识,平台、用户和监管机构需共同努力,在个性化推荐与信息多样性之间寻求平衡,以构建更健康的信息生态。

参考文献

- Sunstein, C. R. (2006). Infotopia: How Many Minds Produce Knowledge. Oxford University Press.

- Pariser, E. (2011). The Filter Bubble: How the New Personalized Web Is Changing What We Read and How We Think. Penguin.

- Zheng, X., & Zeng, D. (2020). Algorithmic Bias in Social Media: A Survey. ACM Computing Surveys.

(全文约1200字)

本文由Renrenwang于2025-04-04发表在人人写论文网,如有疑问,请联系我们。

本文链接:http://www.renrenxie.com/byslw/145.html