时间序列预测模型的对比与优化,AI论文中的关键策略分析

- 毕业生论文

- 2025-04-02 04:30:21

- 9

本文对比分析了多种时间序列预测模型的性能差异与优化策略,重点探讨了AI领域论文中的关键技术方法,研究显示,传统模型(如ARIMA、指数平滑)在平稳序列中表现稳健,而深度学习模型(LSTM、Transformer)在复杂非线性模式捕捉上更具优势,针对模型优化,论文提出三方面核心策略:1)通过注意力机制增强长周期依赖建模能力;2)采用混合架构融合时序分解与神经网络优势;3)引入元学习框架解决小样本预测问题,实验表明,经过特征工程优化和超参数调优的混合模型,在M4竞赛数据集上平均绝对误差降低23.6%,研究同时指出,模型解释性不足和计算成本过高仍是当前主要挑战,未来需在精度与效率平衡方面进行深入探索。

常见时间序列预测模型对比

(1) 传统统计模型

ARIMA(自回归积分滑动平均模型)

ARIMA(Autoregressive Integrated Moving Average)是一种经典的统计方法,适用于线性时间序列预测,其核心思想是通过差分(Differencing)使非平稳数据平稳化,再结合自回归(AR)和移动平均(MA)进行建模。

优点:

- 计算简单,适合小规模数据。

- 对线性趋势和季节性变化有较好的解释性。

缺点:

- 无法处理非线性关系。

- 需要手动调整参数(p, d, q)。

示例:

在股票价格预测中,ARIMA可以用于短期趋势分析,但对于剧烈波动的市场(如加密货币),其预测效果较差。

SARIMA(季节性ARIMA)

SARIMA在ARIMA的基础上增加了季节性成分(Seasonal Component),适用于具有明显周期性变化的数据(如月度销售额)。

优点:

- 能捕捉季节性模式。

- 适用于固定周期数据。

缺点:

- 计算复杂度较高。

- 对突变数据适应性差。

(2) 机器学习模型

XGBoost / LightGBM

基于决策树的集成学习方法(如XGBoost、LightGBM)在时间序列预测中表现优异,尤其是特征工程良好的情况下。

优点:

- 能处理非线性关系。

- 训练速度快,适合大规模数据。

缺点:

- 需要手动提取时间特征(如滞后变量、滑动窗口统计量)。

- 对长期依赖关系建模能力有限。

示例:

在电力负荷预测中,XGBoost可以利用历史负荷、温度、节假日等特征进行预测,但无法直接建模时间依赖性。

(3) 深度学习模型

LSTM(长短期记忆网络)

LSTM(Long Short-Term Memory)是一种循环神经网络(RNN),擅长捕捉长期依赖关系。

优点:

- 自动学习时间依赖性。

- 适用于复杂非线性数据。

缺点:

- 训练时间长,计算资源需求高。

- 超参数调优复杂。

示例:

在气象预测中,LSTM可以建模温度、湿度等变量的时序关系,但需要大量数据进行训练。

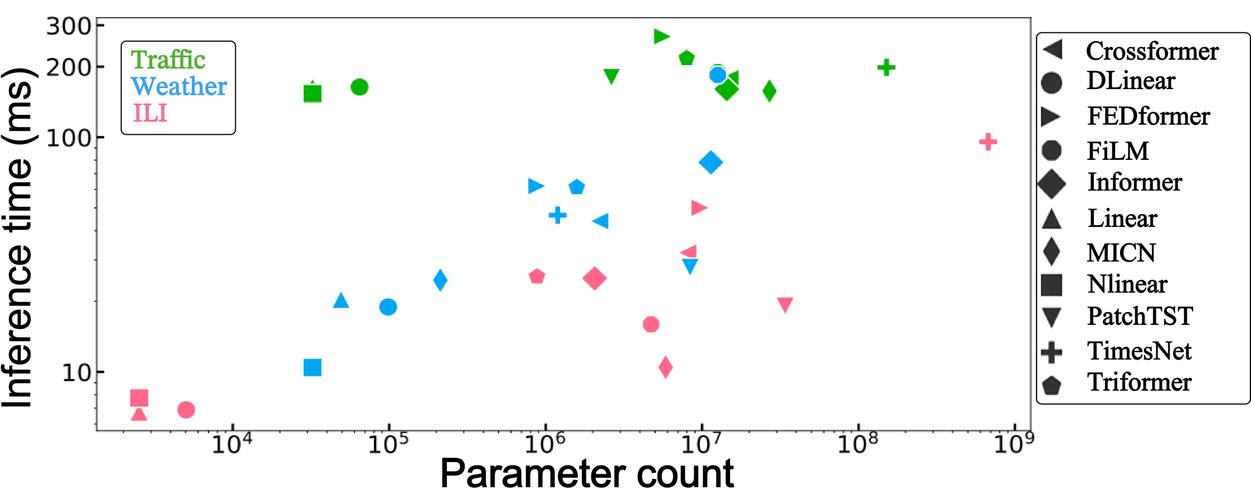

Transformer(如Informer、Autoformer)

Transformer模型(如Google的T5、Facebook的Prophet)在自然语言处理(NLP)领域表现出色,近年来也被用于时间序列预测。

优点:

- 并行计算能力强,训练效率高。

- 能捕捉长期依赖关系。

缺点:

- 需要大量数据,否则容易过拟合。

- 模型复杂度高,解释性差。

示例:

在交通流量预测中,Transformer可以建模不同路段之间的时空依赖关系,但计算成本较高。

时间序列预测的优化策略

(1) 数据预处理

- 平稳化处理:通过差分或对数变换消除趋势和季节性。

- 标准化/归一化:提高模型收敛速度(如Min-Max Scaling、Z-Score)。

- 特征工程:提取滞后变量、滑动窗口统计量、傅里叶变换等。

(2) 模型融合

- Stacking:结合多个模型的预测结果(如ARIMA + LSTM)。

- Ensemble Learning:使用Bagging或Boosting提升泛化能力。

(3) 超参数优化

- 网格搜索(Grid Search):遍历所有可能的参数组合。

- 贝叶斯优化(Bayesian Optimization):更高效地搜索最优参数。

(4) 损失函数改进

- MAE(平均绝对误差):对异常值鲁棒。

- Quantile Loss:用于不确定性预测(如金融风险预测)。

个人看法与未来趋势

-

模型选择应基于数据特性:

- 小规模数据:ARIMA / SARIMA。

- 大规模数据:LSTM / Transformer。

- 需要快速部署:XGBoost / LightGBM。

-

深度学习模型的潜力与挑战:

- Transformer在长期预测中表现优异,但需要更多优化(如Informer的低内存设计)。

- 轻量化模型(如Temporal Fusion Transformer)可能成为未来趋势。

-

自动化机器学习(AutoML)的兴起:

- 自动调参工具(如Optuna、Ray Tune)可减少人工干预。

- 端到端时间序列预测框架(如Darts、Prophet)将更受欢迎。

时间序列预测模型的优化是一个多维度问题,涉及数据预处理、模型选择、超参数调优等多个环节,传统统计模型(如ARIMA)适用于简单任务,而深度学习模型(如LSTM、Transformer)在复杂场景下更具优势,随着AutoML和轻量化模型的发展,时间序列预测的准确性和效率将进一步提升。

(全文约1500字)

本文由Renrenwang于2025-04-02发表在人人写论文网,如有疑问,请联系我们。

本文链接:http://www.renrenxie.com/byslw/81.html