构建生成式AI多模态创作的伦理审查框架,挑战与实践

- 期刊论文

- 2025-04-03 00:48:11

- 11

构建生成式AI多模态创作的伦理审查框架面临技术、法律与伦理的多重挑战,多模态模型(如文本、图像、视频生成)的复杂性使得内容溯源困难,可能引发版权争议与虚假信息传播,关键挑战包括:数据偏见导致的输出歧视、深度伪造技术滥用、创作者权益与AI产出的归属问题,以及跨文化伦理标准的差异,实践中需结合动态审查机制(如实时监测、水印技术)与分层治理,平衡创新与风险,建议建立行业联盟制定伦理准则,嵌入“设计伦理”理念,并通过用户反馈优化模型透明度,未来需推动国际合作,明确责任边界,确保技术向善。

近年来,生成式人工智能(AI)技术飞速发展,尤其是多模态模型(如DALL·E、MidJourney、GPT-4等)能够同时处理文本、图像、音频等多种数据形式,极大地拓展了创作的可能性,随着AI生成内容的广泛应用,伦理问题也日益凸显,如版权争议、虚假信息、偏见传播等,构建一个科学、合理的伦理审查框架,以规范AI多模态创作,已成为行业亟需解决的问题。

生成式AI多模态创作的伦理挑战

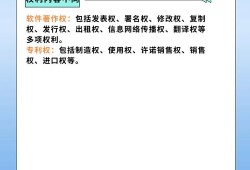

版权与知识产权问题

生成式AI的训练数据通常来自互联网上的公开内容,包括文字、图片、音频等,如果AI直接模仿或复制受版权保护的作品,可能引发法律纠纷。

- Deepfake换脸技术可能未经授权使用名人肖像,侵犯肖像权。

- AI生成画作可能高度模仿某位艺术家的风格,导致原创性争议(如2022年AI画作《太空歌剧院》获奖引发的争议)。

虚假与误导性信息

AI可以生成高度逼真的虚假内容,如伪造的新闻、视频或音频,可能被用于恶意传播虚假信息。

- AI生成的政治演讲视频可能被用于操纵舆论。

- 伪造的医学建议可能误导公众,危害健康。

偏见与歧视

AI模型的训练数据可能包含社会偏见,导致生成内容带有歧视性。

- 文本生成模型可能强化性别或种族刻板印象(如将“医生”默认联想为男性)。

- 图像生成AI可能过度美化或丑化某些群体。

隐私侵犯

AI可能无意中生成包含个人隐私信息的内容,如:

- AI生成的虚构故事可能基于真实人物的数据,侵犯隐私权。

- 语音合成技术可能模仿特定人的声音,用于诈骗。

构建伦理审查框架的关键要素

为了应对上述挑战,我们需要建立一个多层次的伦理审查框架,涵盖技术、法律和社会三个维度。

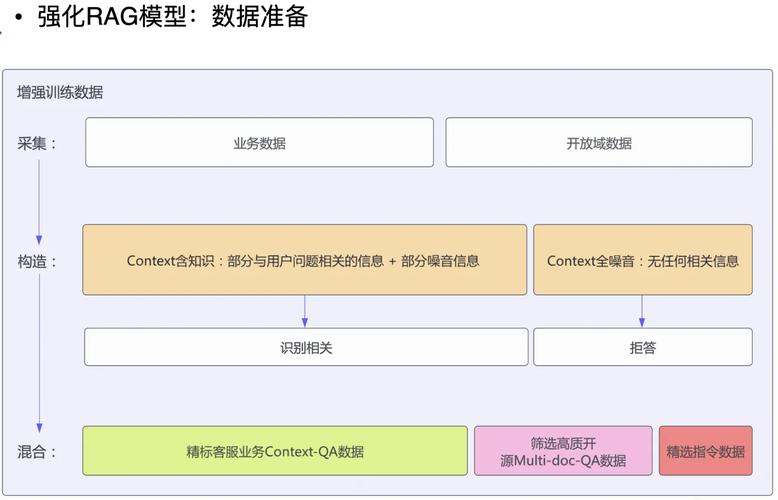

数据来源的透明性与合规性

- 数据采集:确保训练数据合法获取,避免使用未经授权的内容。

- 版权标注:对AI生成内容进行版权声明,明确是否可以商用或二次创作。

- 举例:Adobe的Firefly AI模型仅使用获得授权的图片进行训练,以避免版权纠纷。

内容审核与真实性验证

- 水印技术:在AI生成内容中嵌入数字水印,便于识别来源。

- 事实核查:对AI生成的新闻、学术内容进行人工或自动化审核。

- 举例:OpenAI在ChatGPT中引入“来源引用”功能,减少虚假信息的传播。

偏见检测与公平性优化

- 数据去偏:在训练阶段剔除带有偏见的数据。

- 公平性评估:定期测试AI生成内容是否存在歧视性倾向。

- 举例:Google的PaLM 2模型通过多样化训练数据减少文化偏见。

用户知情权与可控性

- 明确标注AI生成内容:让用户知道他们看到的内容是否由AI生成。

- 用户可干预:允许用户调整AI生成结果的风格或内容,避免被动接受偏见信息。

- 举例:Meta要求AI生成的广告必须标注“由AI辅助创作”。

法律与行业规范协同

- 制定AI伦理准则:如欧盟的《人工智能法案》要求高风险AI系统必须符合透明度要求。

- 行业自律:科技公司可成立伦理委员会,审查AI产品的潜在风险。

- 举例:微软设立AI伦理审查团队,确保产品符合社会价值观。

个人看法:伦理审查的必要性与未来展望

生成式AI的潜力巨大,但缺乏伦理约束可能导致严重后果,我认为:

- 伦理审查不是限制创新,而是保障AI健康发展,合理的规则能让AI更好地服务社会,而非成为隐患。

- 多方协作至关重要,政府、企业、学术界和公众应共同参与制定标准,而非仅依赖科技公司自我监管。

- 未来AI伦理可能成为必修课,就像医学伦理一样,AI开发者需要接受伦理培训,以确保技术向善。

随着AI技术的进步,伦理审查框架也需要不断迭代,区块链技术可能用于追溯AI生成内容的来源,而更先进的审核算法可以实时检测有害内容,只有在技术创新与伦理约束之间找到平衡,AI才能真正成为推动社会进步的力量。

本文由Renrenwang于2025-04-03发表在人人写论文网,如有疑问,请联系我们。

本文链接:http://www.renrenxie.com/kqlw/101.html