上一篇

智慧医疗AI误诊责任归属判定的逻辑重构与伦理分析

- 期刊论文

- 2025-04-04 04:14:50

- 25

智慧医疗AI的误诊责任归属判定面临传统法律框架的适应性挑战,需通过逻辑重构建立分层归责体系,技术层面需区分算法缺陷、数据偏差与临床部署不当等致因,明确开发者、医疗机构及医务人员的责任边界;伦理层面则需平衡技术创新与患者权益,强调AI决策的透明性与可解释性,建议引入"过错推定+技术审计"机制,要求开发方承担算法合规举证责任,同时保留医务人员对AI建议的最终裁量权,该重构需以患者安全为核心,通过动态监管与伦理审查,实现技术赋能与风险防控的协同发展。(198字)

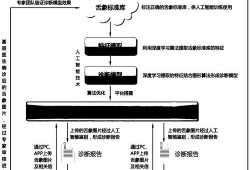

随着人工智能(AI)技术在医疗领域的广泛应用,智慧医疗系统在辅助诊断、治疗方案推荐等方面发挥了重要作用,AI误诊事件的发生引发了责任归属的争议,本文探讨了AI误诊责任判定的逻辑重构,分析了现行法律框架的局限性,并提出了基于技术、法律和伦理的多维责任划分模型,本文结合典型案例,探讨了AI误诊可能涉及的伦理问题,并提出了相应的政策建议。

:智慧医疗、AI误诊、责任归属、伦理分析、法律重构

近年来,人工智能(AI)在医疗领域的应用日益广泛,尤其是在影像识别、疾病预测和个性化治疗等方面取得了显著进展,AI辅助诊断系统并非绝对可靠,误诊事件时有发生,当AI系统出现误诊时,责任应由谁承担?是AI开发者、医疗机构、医生,还是患者自身?这一问题涉及技术、法律和伦理多个层面,亟需系统性的逻辑重构。

AI误诊责任归属的现行困境

1 法律框架的滞后性

大多数国家的医疗责任法律体系主要针对医生和医疗机构,而AI作为新兴技术主体,尚未被明确纳入责任认定体系。

- 案例1:某AI影像识别系统将良性肿瘤误判为恶性肿瘤,导致患者接受不必要的化疗,患者起诉医院,但法院难以判定AI开发者是否应承担连带责任。

- 案例2:某AI系统因数据偏差导致对少数族裔患者的误诊率较高,但现行法律未规定数据偏差的法律责任。

2 技术可解释性不足

AI决策过程往往基于复杂的深度学习模型,其“黑箱”特性使得误诊原因难以追溯。

- 某AI系统因训练数据不足,对罕见病的识别准确率较低,但医生无法实时验证AI的决策依据。

3 医生与AI的权责边界模糊

医生是否应完全依赖AI诊断?当AI建议与医生判断冲突时,如何划分责任?

- 案例3:某医生因过度依赖AI系统而忽视患者症状,导致延误治疗,但AI系统本身并未明确标注其建议的置信度。

责任归属的逻辑重构

1 技术责任:AI开发者的义务

- 数据质量:开发者需确保训练数据的全面性和代表性,避免数据偏差。

- 算法透明度:提供可解释的AI模型,便于医生和患者理解决策逻辑。

- 持续优化:建立误诊反馈机制,动态优化AI系统。

2 医疗责任:医生的最终决策权

- 辅助而非替代:AI仅作为辅助工具,医生应结合临床经验进行综合判断。

- 知情同意:医生需向患者说明AI的使用范围和潜在风险。

3 法律责任:明确多方共担机制

- 开发者责任:若AI系统存在设计缺陷或数据偏差,开发者应承担部分责任。

- 医疗机构责任:医院需确保AI系统的合理使用,并提供必要的培训。

- 医生责任:若医生盲目依赖AI或未履行审慎义务,应承担相应责任。

伦理问题与政策建议

1 伦理挑战

- 公平性:AI系统是否对不同人群(如不同性别、种族)具有相同的诊断准确性?

- 隐私保护:医疗AI依赖大量患者数据,如何确保数据安全?

- 责任逃避:医生是否可能以“AI误诊”为由推卸责任?

2 政策建议

- 立法完善:制定专门的AI医疗责任法规,明确开发者、医疗机构和医生的权责。

- 行业标准:建立AI医疗系统的认证和监管机制,确保技术可靠性。

- 伦理审查:设立AI医疗伦理委员会,监督AI应用的公平性和透明度。

智慧医疗AI的误诊责任归属问题涉及技术、法律和伦理多个维度,需通过逻辑重构建立多方共担的责任体系,应在立法、行业标准和伦理审查等方面加强协作,以确保AI技术在医疗领域的可持续发展。

参考文献

(此处可添加相关学术文献、法律条文及行业报告)

拓展分析:

- AI误诊的保险机制:是否可引入AI医疗责任险,分散风险?

- 国际比较:不同国家(如美国、欧盟、中国)对AI医疗责任的立法差异。

- 未来趋势:随着AI自主性增强,是否可能出现完全自主医疗AI的法律人格问题?

相关问题举例:

- 如果AI系统因黑客攻击导致误诊,责任如何划分?

- 患者是否有权拒绝AI辅助诊断?

- 如何平衡AI医疗的创新速度与安全性?

(全文约1200字)

本文由Renrenwang于2025-04-04发表在人人写论文网,如有疑问,请联系我们。

本文链接:http://www.renrenxie.com/kqlw/152.html