人工智能算法选择中的技术伦理审查,挑战与对策

- 开题报告

- 2025-04-06 00:04:14

- 11

人工智能算法选择中的技术伦理审查面临诸多挑战,主要包括算法偏见、数据隐私、责任归属及社会影响等问题,算法可能因训练数据偏差导致歧视性决策,而数据使用又涉及隐私保护与合规风险,算法决策的透明性不足使得责任界定困难,可能引发公众信任危机,针对这些挑战,对策包括建立多学科伦理审查框架,嵌入算法设计全流程;制定行业标准与法规,确保数据来源合法公平;增强算法可解释性,明确开发者和使用者的责任边界;同时推动公众参与和社会监督,平衡技术创新与伦理约束,未来需通过技术改进、制度完善和跨领域协作,实现人工智能的负责任发展。

随着人工智能(AI)技术的快速发展,算法选择在各类应用中扮演着关键角色,算法的选择不仅涉及技术性能,还涉及伦理问题,如公平性、透明性、隐私保护和责任归属等,本文围绕开题报告中人工智能算法选择的技术伦理审查展开讨论,分析当前面临的伦理挑战,并提出相应的审查框架和优化策略,以确保AI技术的合理、公平和可持续发展。

:人工智能、算法选择、技术伦理、公平性、透明性

人工智能技术在医疗、金融、司法、自动驾驶等领域的广泛应用,使其成为现代社会的重要驱动力,AI算法的选择往往仅基于技术指标(如准确率、效率),而忽视了伦理层面的影响,某些算法可能因训练数据的偏差导致歧视性决策,或因其“黑箱”特性而缺乏可解释性,进而影响用户信任和社会公平,在开题报告阶段对AI算法进行技术伦理审查,是确保项目合规性和社会可接受性的关键步骤。

人工智能算法选择中的伦理挑战

1 数据偏见与算法歧视

AI算法的训练数据可能包含历史或社会偏见,导致算法在性别、种族、年龄等方面产生歧视性结果,招聘算法可能因历史数据中的性别比例失衡而偏向某一性别。

2 算法透明性与可解释性

深度学习等复杂算法通常被视为“黑箱”,其决策过程难以解释,在医疗或司法领域,缺乏透明性可能导致用户对AI决策的不信任,甚至引发法律争议。

3 隐私与数据安全

AI算法通常依赖大量个人数据进行训练,若未采取严格的隐私保护措施,可能导致数据泄露或滥用,违反《通用数据保护条例》(GDPR)等法规。

4 责任归属问题

当AI系统出现错误决策时,责任应由开发者、使用者还是算法本身承担?这一问题在自动驾驶事故或AI医疗误诊中尤为突出。

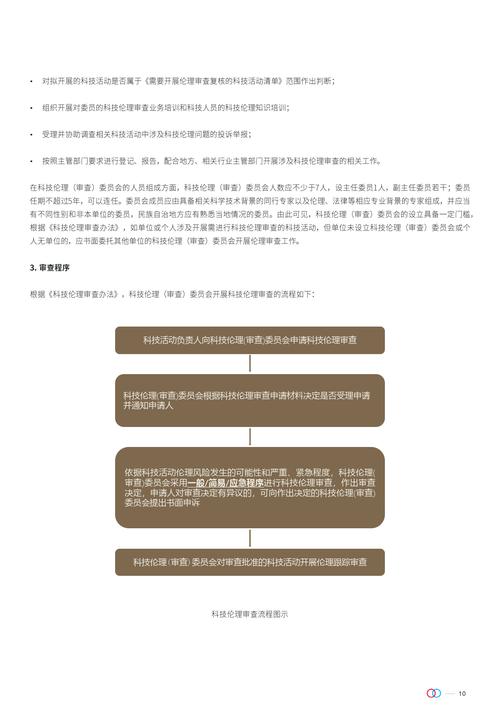

技术伦理审查框架

为确保AI算法的伦理合规性,建议在开题报告中引入以下审查框架:

1 公平性评估

- 检查训练数据是否具有代表性,避免因数据偏差导致歧视性结果。

- 采用公平性指标(如统计均等、机会均等)评估算法对不同群体的影响。

2 透明性与可解释性审查

- 优先选择可解释性强的算法(如决策树、逻辑回归),或在必要时采用可解释AI(XAI)技术。

- 要求算法提供决策依据,确保用户理解其运作逻辑。

3 隐私保护措施

- 采用数据匿名化、差分隐私等技术保护用户数据。

- 确保数据采集、存储和处理符合相关法律法规(如GDPR)。

4 责任与监管机制

- 明确算法开发、部署和使用各方的责任划分。

- 建立AI伦理委员会,定期审查算法的社会影响。

案例分析:AI在金融风控中的应用

以金融风控算法为例,传统信用评分模型可能因历史数据中的种族或地域偏见而歧视某些群体,通过技术伦理审查,可采用以下优化措施:

- 数据去偏:使用合成数据或重新采样以减少偏见。

- 可解释模型:采用逻辑回归而非深度神经网络,提高决策透明度。

- 用户知情权:向用户说明评分依据,并提供申诉渠道。

结论与建议

人工智能算法的选择不仅关乎技术性能,更涉及伦理与社会责任,在开题报告中引入技术伦理审查,有助于预防潜在的伦理风险,提升AI系统的公平性、透明性和可信度,未来研究可进一步探索自动化伦理审查工具,以降低合规成本并推动AI技术的可持续发展。

建议:

- 政府和行业组织应制定AI伦理审查标准。

- 高校和研究机构在AI课程中增加伦理教育。

- 企业设立AI伦理委员会,定期评估算法影响。

参考文献

- Mittelstadt, B. D., et al. (2016). "The ethics of algorithms: Mapping the debate." Big Data & Society.

- Floridi, L., et al. (2018). "AI4People—An ethical framework for a good AI society." Nature Machine Intelligence.

- European Commission. (2019). Ethics Guidelines for Trustworthy AI.

(全文约1200字)

本文由Renrenwang于2025-04-06发表在人人写论文网,如有疑问,请联系我们。

本文链接:http://www.renrenxie.com/ktbg/186.html